Amazon Web Services (AWS) hat neue Updates für Guardrails for Amazon Bedrock angekündigt, die die Sicherheit von generativen KI-Anwendungen verbessern sollen. Zu den Updates gehören eine Halluzinationserkennung und eine unabhängige API, um Anwendungen mit benutzerdefinierten Leitplanken für jedes Modell zu verstärken und so verantwortungsvolle und vertrauenswürdige Ergebnisse zu gewährleisten.

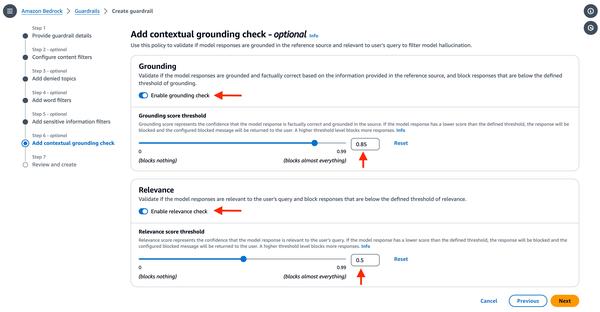

Die Halluzinationserkennung ist eine wertvolle Ergänzung, da sie es Kunden ermöglicht, die Genauigkeit von Modellantworten anhand einer Referenzquelle und einer Benutzerabfrage zu überprüfen. Dies trägt dazu bei, sicherzustellen, dass das Modell keine falschen oder neuen Informationen generiert, die nicht auf Fakten basieren.

Die ApplyGuardrail-API ermöglicht es Kunden, Benutzereingaben und Modellantworten anhand der konfigurierten Sicherheitsvorkehrungen zu bewerten. Diese Funktion ist besonders nützlich für Unternehmen, die selbstverwaltete oder Drittanbieter-LLMs verwenden, da sie es ihnen ermöglicht, einheitliche Sicherheitsstandards für alle ihre Anwendungen anzuwenden.

Mit diesen Updates unterstreicht AWS sein Engagement für die Bereitstellung von Tools und Lösungen, die Kunden beim Aufbau sicherer und vertrauenswürdiger generativer KI-Anwendungen unterstützen. Guardrails for Amazon Bedrock ist ein wichtiger Schritt in diese Richtung, da es Kunden mehr Kontrolle über das Verhalten der von ihnen verwendeten LLMs gibt.

Interessierte Kunden finden weitere Informationen zu diesen neuen Funktionen auf der Produktseite von Guardrails for Amazon Bedrock auf der AWS-Website.