Amazon Web Services (AWS) hat die Einführung von Automated Reasoning Checks (Vorschau) als neue Sicherheitsmaßnahme in Amazon Bedrock Guardrails angekündigt. Diese Funktion hilft, Halluzinationen in großen Sprachmodellen (LLMs) zu reduzieren, indem sie die Genauigkeit der generierten Antworten mathematisch überprüft. Sie basiert auf den Prinzipien des automatisierten Denkens, einem Bereich der Informatik, der mathematische Beweise und logische Deduktion verwendet, um das Verhalten von Systemen und Programmen zu verifizieren. Im Gegensatz zum maschinellen Lernen, das Vorhersagen trifft, bietet automatisiertes Denken mathematische Garantien für das Verhalten eines Systems. AWS verwendet automatisiertes Denken bereits in Schlüsselbereichen wie Speicher, Netzwerk, Virtualisierung, Identität und Kryptografie. Beispielsweise wird automatisiertes Denken verwendet, um die Korrektheit kryptografischer Implementierungen formal zu verifizieren und so sowohl die Leistung als auch die Entwicklungsgeschwindigkeit zu verbessern. Nun wendet AWS einen ähnlichen Ansatz auf generative KI an. Die neuen Automated Reasoning Checks (Vorschau) in Amazon Bedrock Guardrails sind die erste und einzige generative KI-Sicherheitsmaßnahme, die dazu beiträgt, faktische Fehler aufgrund von Halluzinationen zu verhindern, indem sie logisch genaue und überprüfbare Argumentationen verwendet, die erklären, warum generative KI-Antworten korrekt sind. Automated Reasoning Checks sind besonders nützlich für Anwendungsfälle, in denen faktische Genauigkeit und Erklärbarkeit wichtig sind. Sie könnten beispielsweise Automated Reasoning Checks verwenden, um LLM-generierte Antworten zu Personalrichtlinien, Unternehmensproduktinformationen oder operativen Arbeitsabläufen zu validieren. In Verbindung mit anderen Techniken wie Prompt Engineering, Retrieval-Augmented Generation (RAG) und kontextbezogenen Grounding Checks bieten Automated Reasoning Checks einen strengeren und überprüfbareren Ansatz, um sicherzustellen, dass die von LLMs generierte Ausgabe sachlich korrekt ist. Indem Sie Ihr Domänenwissen in strukturierte Richtlinien kodieren, können Sie sicher sein, dass Ihre Conversational-KI-Anwendungen Ihren Benutzern zuverlässige und vertrauenswürdige Informationen liefern.

Verhindern Sie faktische Fehler durch LLM-Halluzinationen mit mathematisch fundierten automatisierten Argumentationsprüfungen (Vorschau)

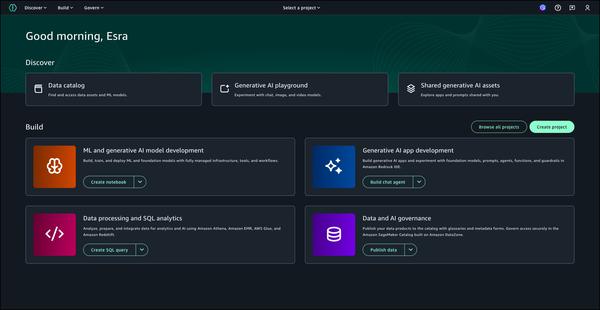

AWS