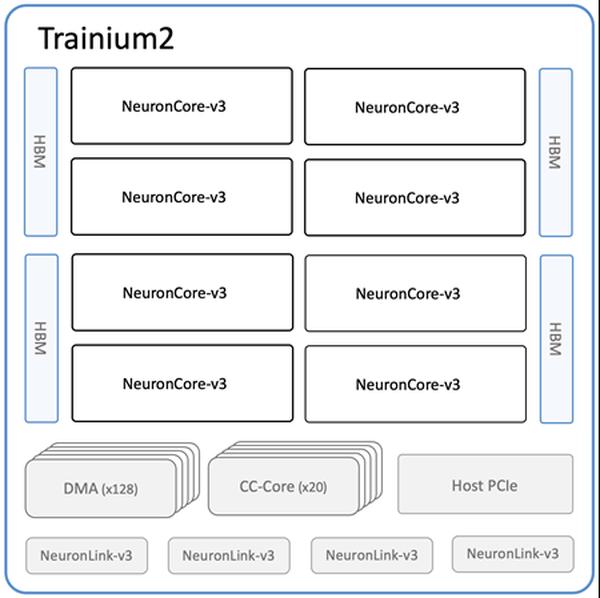

Amazon hat die neuen Amazon EC2 Trn2-Instances und Trn2 UltraServers für KI/ML-Training und Inferenz veröffentlicht. Mit 4x schnellerer Geschwindigkeit, 4x mehr Speicherbandbreite, 3x höherer Speicherkapazität und 30% mehr Gleitkommaoperationen als ihre Vorgänger bieten diese Instanzen eine beispiellose Rechenleistung für ML-Training und generative KI. Die neuen Instanzen sind mit der zweiten Generation von AWS Trainium-Chips (AWS Trainium2) ausgestattet und bieten ein 30-40% besseres Preis-Leistungs-Verhältnis als die aktuelle Generation der GPU-basierten EC2 P5e- und P5en-Instanzen. Jede Trn2-Instanz verfügt über 16 Trainium2-Chips, 192 vCPUs, 2 TiB Speicher und 3,2 Tbps Elastic Fabric Adapter (EFA) v3 Netzwerkbandbreite mit bis zu 50% geringerer Latenz als die vorherige Generation. Die Trn2 UltraServers sind ein völlig neues Computing-Angebot mit 64 Trainium2-Chips, die über eine NeuronLink-Verbindung mit hoher Bandbreite und niedriger Latenz verbunden sind, um maximale Inferenz- und Trainingsleistung für große Sprachmodelle zu erzielen. Zehntausende von Trainium-Chips treiben bereits Amazon- und AWS-Dienste an. Beispielsweise unterstützten über 80.000 AWS Inferentia- und Trainium1-Chips den Rufus-Shopping-Assistenten am letzten Prime Day. Trainium2-Chips treiben bereits die latenzoptimierten Versionen der Llama 3.1 405B- und Claude 3.5 Haiku-Modelle auf Amazon Bedrock an. Trn2-Instanzen sind ab sofort für den Produktionseinsatz in der AWS-Region US East (Ohio) verfügbar und können über Amazon EC2 Capacity Blocks für ML reserviert werden. Softwareseitig können Sie mit den AWS Deep Learning AMIs beginnen, die mit Frameworks und Tools wie PyTorch, JAX und mehr vorkonfiguriert sind.

Amazon EC2 Trn2-Instances und Trn2 UltraServers für KI/ML-Training und Inferenz jetzt verfügbar

AWS