Google Cloud hat die Veröffentlichung des neuen Ray Operators auf GKE angekündigt, der die Skalierung von Ray-Workloads in Produktionsumgebungen vereinfacht. Diese Integration bietet Unternehmen eine effiziente Möglichkeit, Aufgaben auf mehrere Maschinen zu verteilen, insbesondere da generative KI-Modelle immer größer und komplexer werden.

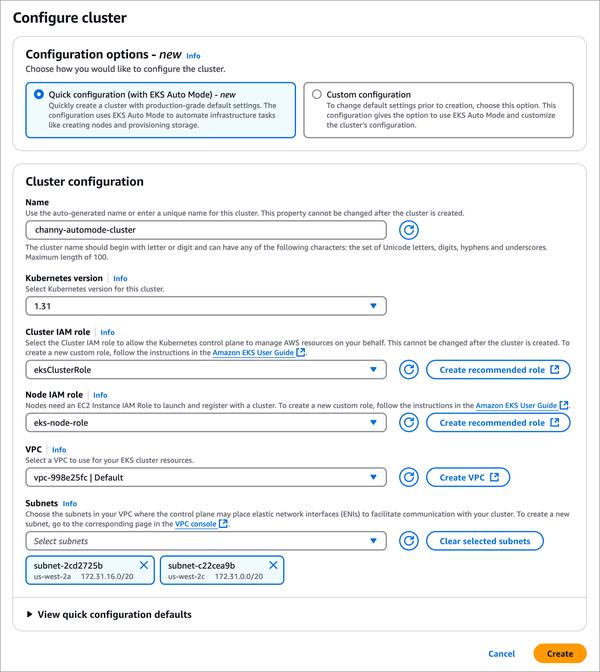

Ein Aspekt, der mich besonders beeindruckt hat, ist die Benutzerfreundlichkeit des Ray Operators. Durch die Aktivierung deklarativer APIs können Benutzer Ray-Cluster auf GKE jetzt mit einer einzigen Konfigurationsoption verwalten. Dies reduziert die Komplexität des Einrichtungsprozesses und ermöglicht es Entwicklern, sich auf das Erstellen und Bereitstellen ihrer KI/ML-Anwendungen zu konzentrieren.

Darüber hinaus unterstützt das neue Add-on Funktionen wie Protokollierung und Überwachung, die den Benutzern wertvolle Einblicke in die Leistung ihrer Anwendungen bieten. Die Integration von Cloud Logging und Cloud Monitoring macht es einfach, Engpässe und Ressourcenfehler zu identifizieren und so einen reibungslosen Betrieb der Ray-Workloads zu gewährleisten.

Schließlich ist die zusätzliche Unterstützung für TPUs eine willkommene Ergänzung. Durch die Nutzung der AI Hypercomputer-Architektur von Google können Benutzer nun die Leistung von TPUs nutzen, um Trainings- und Inferenzaufgaben zu beschleunigen. Diese Funktion ist besonders für Unternehmen von Vorteil, die große Modelle verarbeiten und schnelle Verarbeitungszeiten benötigen.

Insgesamt ist der neue Ray Operator auf GKE ein bedeutender Schritt, um verteiltes Computing zugänglicher zu machen. Durch die Vereinfachung der Clusterverwaltung, die Verbesserung der Ressourcenüberwachung und die Unterstützung dedizierter Hardwarebeschleuniger ermöglicht Google Cloud Unternehmen, das volle Potenzial von Ray für KI/ML in der Produktion auszuschöpfen.