Google Cloud hat einen Leitfaden zur Handhabung von 429-Fehlern aufgrund von Ressourcenerschöpfung veröffentlicht, insbesondere bei der Verwendung großer Sprachmodelle (LLMs). Der Artikel betont die Wichtigkeit der Verwaltung des Ressourcenverbrauchs, um ein reibungsloses Benutzererlebnis zu gewährleisten, da LLMs erhebliche Rechenressourcen benötigen. Drei Hauptstrategien werden zur Bewältigung dieser Fehler vorgestellt:

1. **Backoff und Wiederholung:** Verwenden Sie exponentielle Backoff- und Wiederholungslogik, um Ressourcenerschöpfung oder API-Nichtverfügbarkeit zu behandeln. Die Wartezeit erhöht sich mit jedem Wiederholungsversuch exponentiell, bis sich das überlastete System erholt.

2. **Dynamische gemeinsame Kontingente:** Google Cloud verwaltet die Ressourcenzuweisung für bestimmte Modelle, indem es dynamisch einen Pool verfügbarer Kapazität auf alle Benutzer verteilt, die Anfragen stellen. Dies verbessert die Ressourceneffizienz und reduziert die Latenz.

3. **Provisionierter Durchsatz:** Mit diesem Dienst können Sie dedizierte Kapazität für generative KI-Modelle auf der Vertex AI-Plattform reservieren und so eine vorhersehbare und zuverlässige Leistung für Ihre KI-Workloads gewährleisten, selbst bei Spitzenauslastung.

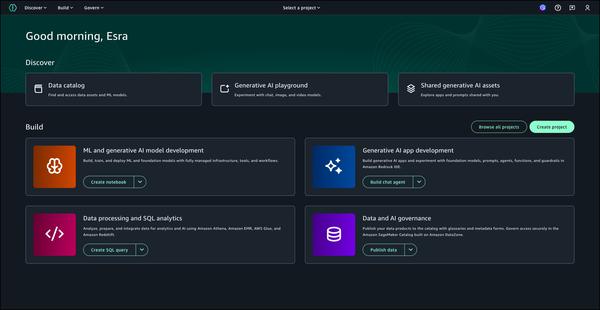

Der Artikel hebt die Notwendigkeit hervor, Backoff- und Wiederholungsmechanismen mit dynamischen gemeinsamen Kontingenten zu kombinieren, insbesondere wenn das Anfragevolumen und die Tokengröße zunehmen. Weitere Optionen wie die Überschreibung von Verbraucherkontingenten und der provisionierte Durchsatz werden ebenfalls für die Widerstandsfähigkeit von LLM-Anwendungen erwähnt. Der Artikel schließt mit der Ermutigung, mit generativer KI zu entwickeln, indem Vertex AI-Beispiele auf GitHub verwendet oder der Anfängerleitfaden, Schnellstarts oder das Starterpaket von Google Cloud genutzt werden.